딥시크 양조장

by 김상훈

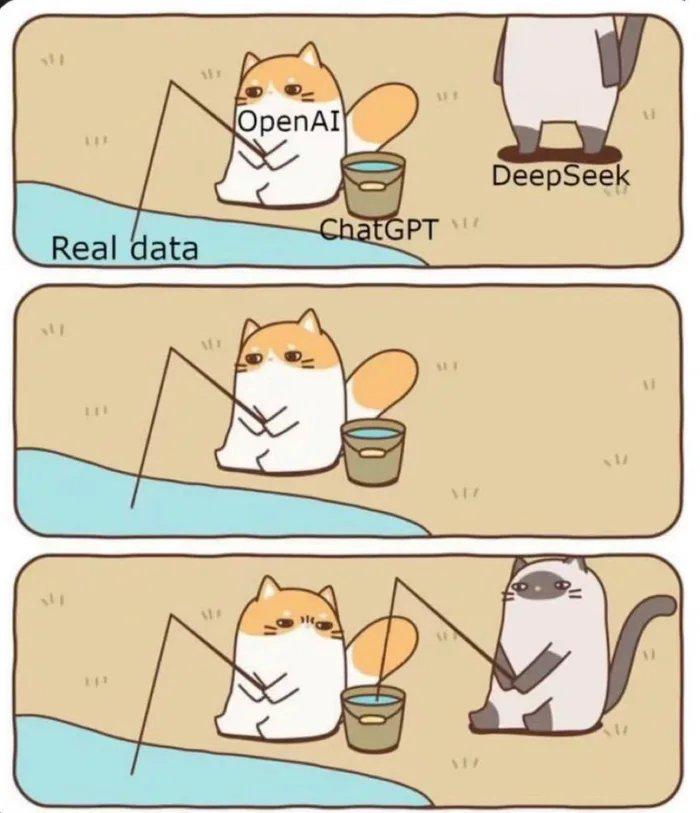

딥시크(DeepSeek)가 왜 AI 엔지니어들의 영역을 벗어나 온 세상을 시끄럽게 하는지 아래 그림 한 장이 잘 설명한다. 이른바 증류(distillation)라고 불리는 기법 때문이다.

ChatGPT는 우리 눈을 현혹시켰다. 너무나 그럴싸한 답변을 내놓아 사람인지 기계인지 구별하기 힘들어서다. 이 놀라운 능력의 기반은 근본적으로 더 많은 데이터에 있다. 오늘날의 AI는 인간이 AI를 처음 연구하던 수십년 전과 근본적인 차이가 있는데, 1) 방대한 데이터가 인터넷을 통해 쉽게 접근 가능한 수준으로 디지털화됐고, 2) 이 방대한 데이터를 동시에 처리할 수 있는 어마어마한 하드웨어(엔비디아 칩 등) 인프라가 마련됐기 때문이다.

오픈AI 같은 대규모언어모델(LLM) 회사는 이 거대한 데이터를 활용해 ChatGPT라는 결과물을 만들어 낸다. 하지만 쉬운 일도, 값싼 일도 아니다. 좋은 데이터(책, 영화, 뉴스, 사진 등)일수록 소유자가 있고, 소유자들은 오픈AI가 자신들의 데이터를 무료로 활용하는 걸 반대하며 법적 분쟁도 불사하기 때문에 1)을 확보하려면 비용이 생각보다 많이 든다. 그렇다고 2)가 싼 것도 아니다. 오픈AI가 세계적인 성공을 거두자 구글도, 아마존도, 테슬라도 이 시장에 뛰어들었고 동시에 엔비디아칩의 가격은 천정부지로 올랐다. 반응은 연쇄적이어서, 엔비디아칩을 설치할 데이터센터 건설비도, 부지 확보 비용도, 그 데이터센터를 돌릴 전기료도 모두 함께 오르고 있다.

딥시크가 사용한 증류 기법은 이런 상황에서 생겼다. 발상의 전환이었다. AI의 답변은 기본적으로 통계에 기반해 높은 확률의 정답을 뽑아주는 것에 가깝다. 따라서 ChatGPT 같은 기존 AI들은 질문을 받았을 때 거대한 데이터를 돌려서 적절한 답을 출력한다. 최종 사용자는 인식하지 못하지만 질문이 입력되는 순간 저 먼 곳 어딘가의 데이터센터에서 AI가 수많은 계산을 벌이고, 정답에 가까운 근사값들을 뽑아낸 뒤, 그 중 하나의 정답을 선택해 사용자에게 제시한다.

예를 들어, 거대한 도서관(인터넷)에 다가가 사서에게 "새우튀김을 바삭하게 튀기는 법에 대한 요리책을 찾아줘"라고 부탁한다 가정해 보자. 기존의 사서(옛 AI)들은 '새우튀김'이라는 표제어의 책을 찾거나, '요리책' 분류의 서가를 뒤진다. 수십-수백권 정도의 책을 수십분 정도 뒤지면 가능한 일이지만 불편하고 부정확하다. 반면 ChatGPT 같은 사서는 머릿속에 도서관의 모든 책을 기억해 두고, 예전 도서관 방문자들의 모든 요청도 기억해 둔다. 심지어 어떤 책을 꺼내줬을 때 사용자의 추가 요청은 없었는지, 만족한다는 피드백을 남겼는지도 동시에 고려한다. 전통적인 사서는 할 수 없는 일이었지만 데이터센터와 엔비디아칩으로 무장한 ChatGPT 사서라면 가능하다. 방문자는 ChatGPT 사서에게 한 권의 책을 정답(hard target)으로 받게 되지만, 이 책을 제시하기 위해 ChatGPT 사서는 뒷켠에 수십권의 유사한 책(soft target)도 쌓아놓는다.

증류 기법은 여기서 등장한다. ChatGPT처럼 수억권의 책을 기억하는 대신 ChatGPT 같은 거대 모델을 미리 만들어 두고, 이 모델이 만들어 놓은 수십권의 책들(soft target)만 가지고 사서(DeepSeek)를 교육시키면 어떨까? 방문자가 요리책을 요청할 때, ChatGPT는 도서관 전체를 뒤져보고 답을 내놓아야 하지만, 딥시크는 요리책 전문 사서에게 배운 요령을 활용해 적절한 답을 내놓기 때문에 수백 수천배 쉽고 빠르게 답할 수 있지 않을까? 수천가지 분야에 대해 수십권의 정보를 저장하는 일은 엄청나 보이지만, 수억권의 책을 한번에 파악하고 답을 내는 것과 비교하면 훨씬 쉬운 일이다.

여기서 가장 중요한 질문이 등장한다. 그렇다면, 딥시크가 학습을 위한 거대 모델을 스스로 만들지 않고 이미 외부에 존재하는 거대 모델(ChatGPT, Gemini, Claude 등등)을 활용했다면 어떻게 되는 걸까?

기존 AI회사들은 이미 약관을 통해 다른 AI 기업이 학습 목적으로 자신들의 AI를 쓰지 못하도록 규정을 마련해 놓았다. 하지만 규정을 마련했다고 질문을 던지고 답을 얻는 과정 자체를 차단할 수는 없다. 그래서 오픈AI는 딥시크를 거꾸로 분석해 이 회사가 자신들의 AI를 활용한 증거를 수집하고 있다. 아래 그림이 뜻하는게 바로 이런 얘기다.(물론 딥시크는 이런 오픈AI의 주장을 인정하지 않았다.)

오픈AI와 딥시크 사이의 갈등은 사실 기업 간 갈등에 지나지 않는다. 산업으로 보면 더 심각하다. ChatGPT 같은 새로운 AI는 끝내주는 성능을 갖췄지만 학습에 필요한 데이터 확보에도, 작동에 필요한 전력 확보에도 모두 어마어마한 비용을 쓴다. 딥시크가 활용해 효용을 입증한 증류 모델은 이 비용 투자를 무력화한다.

증류니까 증류주에 비교해 보자. 증류식 소주 한 병을 제대로 만들려면 논을 사서, 볍씨를 뿌리고, 쌀을 수확한 뒤, 발효시켜 찌꺼기를 가라앉히고, 청주를 만들어 이 청주를 또 증류해야 한다. ChatGPT 같은 새로운 AI들은 논을 사서 쌀을 수확하고, 청주를 빚어 소주를 증류하는 모든 과정을 직접 진행한다. 그런데 누군가 이 과정을 건너뛰고 ChatGPT 양조장에서 청주만 훔쳐내어 소주를 빚는다면?

이게 지금 투자자들을 패닉에 빠뜨린 이유다. 현실의 양조장이라면 도난방지 등의 물리적 억제로 청주를 지킬 수 있지만, AI는 상대가 누구라도 질문을 던지면 답변을 제공한다. 물리적 억제가 의미없다는 뜻이다. 상황이 이런데 엔비디아칩과 데이터센터, 발전소 건설에 수십조를 투자하는 게 과연 의미가 있을까? 군비 경쟁 시기였다면 내가 만들어 쌓아놓은 무기가 후발주자와의 격차를 늘리는 투자였다. AI 경쟁 시기에는 내가 만들어 쌓아놓은 인프라가 후발주자의 무임승차에 사용되는 낭비가 되고 있는지도 모른다. 투자자들의 심리가 순간적으로 얼어붙은 이유다.